JE STEM VERRAADT HOE JE ERUIT ZIET Niets zo persoonlijk als onze eigen stem; en wat blijkt: onze stem blijkt veel informatie te bevatten over bijvoorbeeld ons gedrag, identiteit, emoties en onze mentale gezondheid.

Snelheid van spreken, volume, pauze tussen woorden, gebruik van “ehmm”, klemtoon, accent / dialect, vocabulaire, benadrukken van bepaalde woorden: in onze stem zitten veel informatiepunten.

Want nu steeds meer toepassingen en apparaten de mogelijkheid krijgen tot stembesturing, ontdekken commerciële bedrijven de waarde van deze biometrische data. En deze data kan over het algemeen makkelijk geoogst worden.

In de commerciële context kan deze software bijvoorbeeld gebruikt worden om te voorspellen of iemand zijn lening wel of niet terug gaat betalen, (!) of kan het door verzekeraars gebruikt worden in het voorselectietraject van bijvoorbeeld een arbeidsongeschiktheidsverzekering. Wanneer iemands stem bijvoorbeeld verraadt of hij of zij gevoelig is voor psychische problemen.

Het risico is natuurlijk dat mensen, terecht of onterecht, bij de deur van de verzekeraar al worden geweigerd omdat ze mogelijk een hogere kans hebben op een bepaalde fysieke of mentale klacht.

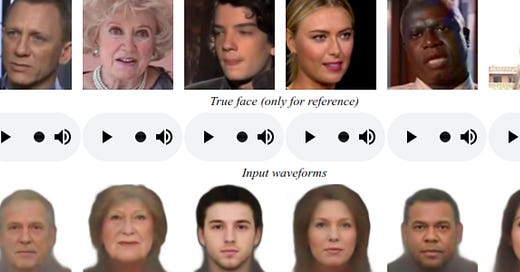

Een interessant fenomeen: een kunstmatig intelligent systeem kan een beeld creëren van iemands uiterlijk, gebaseerd op zijn of haar stem .

Wat heb je nodig: slechts een korte audio clip van iemands stem en dit AI systeem raadt vervolgens met redelijke precisie het uiterlijk van hem of haar.

Dit systeem is getraind op vele uren YouTube materiaal: daar heeft het AI systeem het verband tussen uiterlijke kenmerken en de stem (klankkleur, snelheid, tone of voice et cetera) weten te leggen.

Vorig jaar bleek een kunstmatig intelligent systeem al goede voorspellingen te kunnen doen over iemands lengte, gewicht, gezichtsstructuur, sociaal economische achtergrond, en leeftijd op basis van opgenomen spraak .

Dat systeem was zelfs in staat om te bepalen in wat voor soort ruimte je zat én of er ook onregelmatige fluctuaties te registreren waren in het elektriciteitsnetwerk, wat kenmerkend is voor een bepaald gebied of stad.

Je spraak verraadt hoe je eruit ziet. Check HIER het artikel en de voorbeelden.

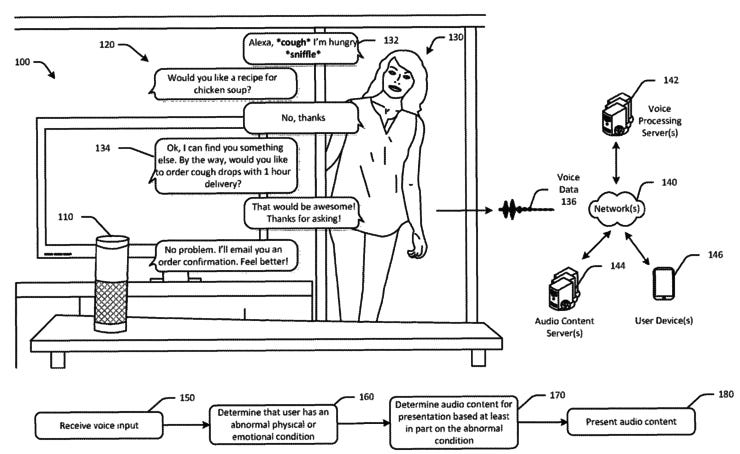

Wij gebruiken steeds vaker onze stem om technologie aan te sturen. Slimme speakers, spraak naar tekst, slimme apps, voice commands. Amazon heeft vorig jaar al een patent aangevraagd waarmee een aantal persoonlijke eigenschappen kunnen worden bepaald op basis van je stem. Denk aan:

Identiteit: geslacht, leeftijd, etnische afkomst, et cetera.

Gezondheid: keelpijn, ziekte et cetera.

Emoties: geluk, vreugde, woede, verdriet, verdriet, angst, walging, verveling, stress.

In dit patent voorbeeld is Alexa in gesprek met een vrouw die zich verkouden voelt. Alexa detecteert dat en stelt haar het recept kippensoep voor op basis van haar verkoudheid. Op een later moment stemt de vrouw in met de aankoop van hoestsnoepjes, die binnen een uur bezorgd worden. Alexa snapt steeds beter wie je bent, wat je doet en waarom je dat dan doet. Bovenstaande voorbeelden zijn het laaghangende fruit. Deze voice analytics technologie wordt steeds slimmer.

Alexa zal in de toekomst ook steeds empathischer gaan reageren op je vragen, commando's of opmerkingen. Wellicht gaat ze je in de toekomst opvoedingstips geven wanneer het merkt dat je vaak met stemverheffing spreekt tegen je kinderen of relatietherapie advertenties voorschotelen wanneer het spanningen bemerkt tussen jou en je partner. Ook moeten we ons bewust zijn van het risico dat dit soort software maatschappelijke vooroordelen en stereotyperingen in zich herbergen en op basis daarvan reageren/ adviezen geven/ advertenties voorschotelen.

ps: (Het bedrijf Affectiva kan trouwens binnen 1,2 seconden al vaststellen of iemand aan de telefoon boos is of niet)

Een veelbelovend onderzoek waarbij posttraumatische stressstoornis (PTSS) kan worden gedetecteerd door stemanalyse. In dit onderzoek werden 129 veteranen geïnterviewd: 40.000 spraaksamples werden verzameld. Het kunstmatig intelligent systeem heeft na uitgebreid testen geleerd welke 18 indicatoren samenhangen met posttraumatische stress.

.. Trager en meer monotoon spreken, een korter toonbereik, spanning van de keelspieren en of de tong de lippen raakt waren allemaal mogelijke indicatoren voor een PTSS diagnose. Het algoritme kan volgens de onderzoekers PTSS met 89% nauwkeurigheid diagnosticeren.

Snel, lage kosten en gewoon vanuit thuis. Dat is de belofte van dit systeem.

"This could take some of the fuzziness out of the process, and help clinicians make better decisions.”

Dit onderzoek kan helpen om de diagnose sneller boven tafel te krijgen: Moeilijke situaties uit de dagelijkse praktijk van de psychologenpraktijk zijn: bijvoorbeeld wanneer patiënten zich schamen voor hun symptomen en ze bagatelliseren, of symptomen juist aandikken om een grotere financiële vergoeding te krijgen van hun werkgever.

De vraag blijft uiteindelijk wel; wat laten we bij diagnostisering over aan de machine en wat bepaalt de specialist?

Belangrijke voetnoot: veel patiënten met PTSS zijn ook depressief én gebruikers van drugs. Er moet daarom nu verder onderzocht worden of het bovengenoemde verband van 89% wel of niet gerelateerd is aan deze kenmerken.

ps: MIT spinoff Cogito werkt samen met het Amerikaanse Ministerie om tekenen van posttraumatische stressstoornis (PTSS) bij veteranen op te sporen. Het bedrijf heeft hiervoor een mobiele app ontwikkeld die passief de smartphone-sensoren monitort en informatie uit stemopnames en sms'jes te detecteren. En deelnemers worden ook gevraagd om enquêtes in te vullen over hun geestelijke gezondheid.

Het bedrijf Winterlight gebruikt een AI systeem om cognitieve problemen, zoals Alzheimer te detecteren. Daarvoor gebruiken ze audio opnames van ongeveer een minuut.

Winterlight test patiënten door hen een foto te laten zien van een dagelijks voorwerp en deze door hen te laten beschrijven.

Het kunstmatig intelligent systeem test vervolgens de audio opname van de stem op 400 variabelen. Wat blijkt: mensen met Alzheimer hebben bijvoorbeeld moeite om bepaalde woorden te vinden, gebruiken langere pauzes tussen de woorden in, twijfelen meer en gebruiken veel minder complexe woorden.

Met deze software kan in de toekomst wellicht sneller de diagnose van Alzheimer worden vastgesteld en in een vroeger stadium worden behandeld. Een vroege diagnose en behandeling kan leed voorkomen.

Dit kunstmatig intelligent systeem is in staat om een hartstilstand te detecteren op basis van een telefoongesprek. Sommige meldkamers in Europa maken er gebruik van.

Dit AI systeem is maar liefst 30 seconden sneller dan een menselijke hulpverlener en heeft bij het bepalen van een hartstilstand een nauwkeurigheid van 93%, waarbij de telefonisch hulpverleners slechts 73% nauwkeurigheid behaalt.

De medewerker krijgt, bij een positieve match, tips op zijn of haar beeldscherm te zien hoe om te gaan met een patiënt met een hartstilstand.

Op het Wall Street Journal 'Future of Everything" festival werden twee Amazon ontwikkelaars gevraagd naar de huidige status en toekomst van Alexa.

-Alexa leert snel:

Van gebruikers ; wanneer Alexa een gestelde vraag niet helemaal lijkt te begrijpen, formuleren mensen een andere vraag voor Alexa. Het Alexa systeem koppelt beide commando's dan aan elkaar en leer daarvan.

Ook transfer learning wordt steeds beter: wanneer het Alexa systeem bijvoorbeeld een taal beheerst (Engels), is het makkelijker om een volgende taal te leren. (Duits)

Het Alexa systeem leert ook van Amazon developers: zij luisteren naar samples en labelen handmatig de betekenis ervan. Daar leert het systeem van.

Er zijn inmiddels 100 miljoen mensen wereldwijd die Alexa gebruiken. Elke dag stroomt er dus een enorme hoeveelheid data richting Amazon.

Meest gebruikte features:

Cogito maakt software voor de callcenter industrie. Het systeem detecteert emoties van klanten én medewerkers.

Wordt een klant emotioneel? Dan krijgt de medewerker een afbeelding van een hart op zijn scherm.

Klinkt de medewerker vermoeid of traag: dan krijgt hij een afbeelding van een kop koffie op zijn scherm. Een speedometer laat de medewerker de “gewenste snelheid” van spreken zien. Vaak blijken medewerkers te snel te spreken.

Klinkt een klant geïrriteerd? Dan krijgt de medewerker tips op zijn beeldschermte zien hoe om te gaan met een geïrriteerde klant.

Zo garandeer je als bedrijf dat je medewerkers altijd optimaal functioneren aan de telefoon. Medewerkers krijgen dus “coaching” van het kunstmatig intelligent systeem. Ze moeten daarvoor wel iets van hun autonomie inleveren.

Voetnoot:

Wanneer wij in de toekomst steeds meer geholpen gaan worden door kunstmatig intelligente systemen die ons signalen geven over de emotionele toestand van onze gesprekspartner:

---Is dat positief ? .. leren we zo beter om iemands emotie op basis van spraak te herkennen?

---Of negatief : .. dat we lui en gemakzuchtig worden en het detecteren van emotionele signalen in een gesprek liever overlaten aan de software? Dat we onze emotionele antennes minder goed trainen en dat ze daardoor minder goed afgesteld komen te staan? Gaat het ten koste van wat ons mens maakt?

Kunstmatig intelligente systemen worden steeds intelligenter. Ze nemen steeds meer menselijke vaardigheden van ons over en geven ons tevens bovenmenselijke cognitieve capaciteiten. Hier gaan we als mens en samenleving enorm de zoete vruchten van plukken, maar deze krachtige technologie kent ook risico's.

Kunstmatig intelligente systemen nemen bijvoorbeeld steeds vaker belangrijke beslissingen die van invloed zijn op ons leven. En wanneer ze menen emoties bij mensen te kunnen detecteren of werelden kunnen creëren die niet meer van echt te onderscheiden zijn, moeten we gezond kritisch zijn. Tijd om ook daar naar te kijken. En wanneer software precies weet wie we zijn, wat we willen en continu het dagelijkse ongemak voor ons wegnemen; is dat een zegen of een vloek?

Ik kom tevens met oplossingen, bijvoorbeeld de noodzaak tot individuele emotionele introspectie.

Ik geef graag lezingen over tech-trends en over de impact van nieuwe technologie op mens, werk en samenleving. Voel je vrij om contact met me te leggen! info@jarnoduursma.nl 0616074953

Disclaimer: De inhoud is uitsluitend bedoeld voor informatieve doeleinden en mag niet worden opgevat als juridisch, zakelijk, fiscaal of beleggingsadvies. Het is geen aanbod, suggestie of verzoek om een investering te doen. In het bijzonder is de inhoud niet gericht op een belegger of potentiële belegger en mag niet worden gebruikt om een belegging te evalueren of te doen.

Wij gebruiken steeds vaker onze stem om technologie aan te sturen. Slimme speakers, spraak naar tekst, slimme apps, voice commands. Amazon Alexa lijkt op dit moment het meest geavbanceerd.

Amazon heeft vorig jaar bijvoorbeeld al een patent aangevraagd waarmee een aantal persoonlijke eigenschappen kunnen worden bepaald op basis van je stem. Denk aan identiteit: geslacht, leeftijd, etnische afkomst et cetera. Gezondheid: keelpijn, ziekte et cetera. Emoties: gelukkig, verdrietig, moe, slaperig, opgewonden et cetera.

In dit voorbeeld is Alexa in gesprek met een vrouw die zich verkouden voelt. Alexa detecteert dat en stelt het haar recept "kippensoep" voor op basis van wat het detecteert. Op een later moment stemt de vrouw in met de aankoop van hoestsnoepjes, die binnen een uur bezorgd worden.

Alexa snapt steeds beter wie je bent, wat je doet en waarom je dat dan doet. Bovenstaande voorbeelden zijn het laaghangende fruit. Deze voice analytics technologie wordt steeds slimmer. Alexa zal in de toekomst ook steeds empathischer gaan reageren op je vragen, commando's of opmerkingen. Wellicht gaat dat je in de toekomst opvoedingstips geven wanneer het merkt dat je vaak met stemverheffing spreekt tegen je kinderen of relatietherapie advertenties voorschotelen wanneer het spanningen bemerkt tussen jou en je vrouw.

Ook moeten we ons bewust zijn van het risico dat ook de spraakmachines maatschappelijke vooroordelen en stereotyperingen in zich hebben en op basis daarvan reageren/ adviezen geven/ advertenties voorschotelen.

Ik heb het dan nog niet eens over de beveiliging van je spraakgegevens; zowel bij Amazon als ten opzichte van je huisgenoten; ieder commando is terug te vinden in de app. Maar goed; dat is wat mij betreft een van de mindste zorgen.